Kunstig intelligens er informasjonsteknologi som justerer sin egen aktivitet og derfor tilsynelatende framstår som intelligent.

Man sier ofte at en datamaskin som er i stand til å løse oppgaver uten å få instruksjoner fra et menneske om hvordan den skal gjøre det, har kunstig intelligens. For eksempel foreslår «intelligente» søkemotorer treff på grunnlag av data om tidligere søk og annen brukeradferd. Dette kalles maskinlæring, og har en lang rekke bruksområder, fra enkle programmer i smarttelefoner til chatbots og selvkjørende biler. Det finnes også kunstig intelligens som ikke lærer, for eksempel såkalte regelbaserte systemer, hvor komplekse regler for «intelligent adferd» er spesifisert av mennesker på forhånd.

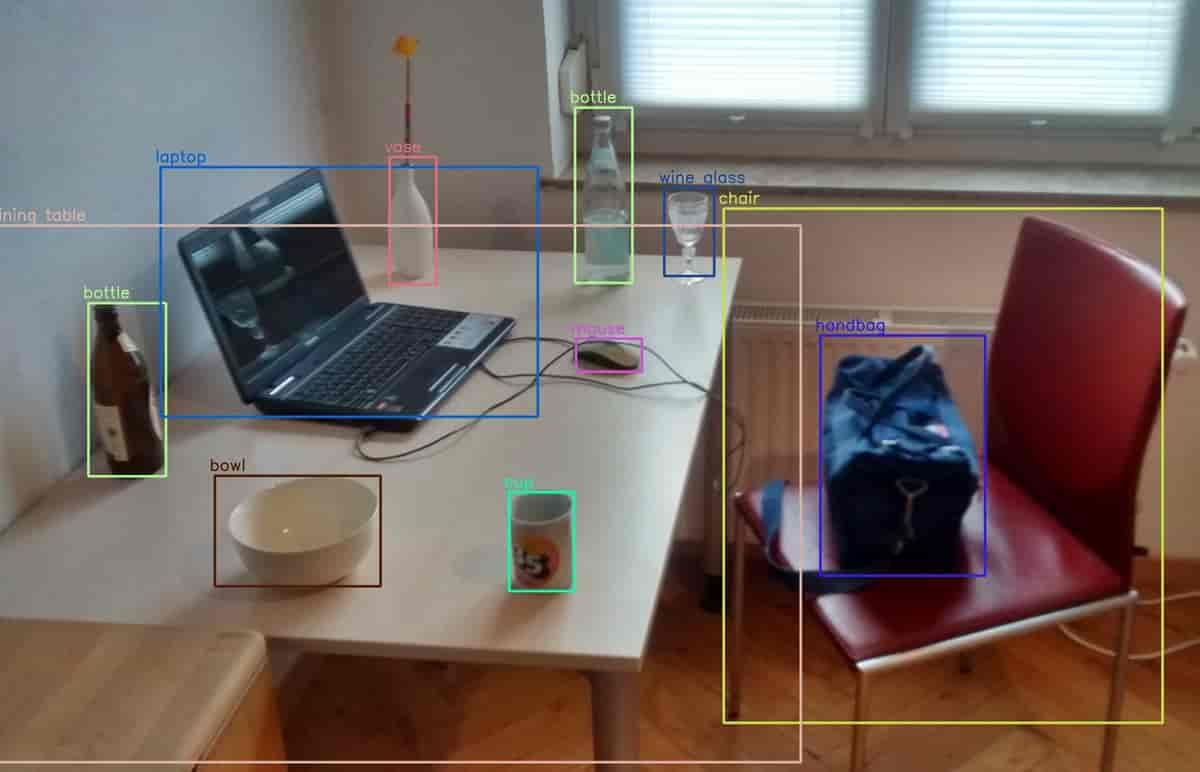

Det arbeides spesielt mye med kunstig intelligens innen språkteknologi, talegjenkjenning, bildegjenkjenning, brukerinteraksjon og styring av fysiske prosesser. Når det snakkes om kunstig intelligens, refereres det som regel til såkalt dype nevrale nettverk eller dyp læring.

Mot slutten av 2022 kom generativ kunstig intelligens på banen for fullt. Denne teknologien baserer seg på dyp læring for å gjengi statistiske egenskaper av det opprinnelige materialet modellen er trent på, og har fått enormt mye oppmerksomhet i media.

Som fagfelt er kunstig intelligens en sammensmelting av datateknikk, logikk, matematikk, psykologi og nevrovitenskap. Begrepet har vært en del av datateknikken siden 1950-årene, men det er særlig siden 2010-tallet at teknologien har fått stor utbredelse. I dag er kunstig intelligens en vital del av utviklingen innen informasjonsteknologi, og introduseres på stadig nye felt.

Kommentarer (3)

skrev Gedi S

Veldig bra skrevet artikler Axel! Hvor/hvordan man kan abonnere på deres artikler?

mhv,

g

skrev Ola Nordal

Hei Gedi. Jeg takker på vegne av Axel. Det varmer å høre at du liker artikkelen! Hvis du vil få jevnlige oppdateringer om gode og aktuelle artikler kan du følge oss på facebook. Vi poster artikler vi er glade i og stolte av hver dag. Det er også mulig å følge oss på Twitter. Søk, så finner du oss.

Alt godt fra Ola i SNL-redaksjonen

skrev Axel Tidemann

Takk for tilbakemeldingen, Gedi! Flott å høre at du liker artikkelen.

Kommentarer til artikkelen blir synlig for alle. Ikke skriv inn sensitive opplysninger, for eksempel helseopplysninger. Fagansvarlig eller redaktør svarer når de kan. Det kan ta tid før du får svar.

Du må være logget inn for å kommentere.